熟练使用各类敏感目录文件扫描工具

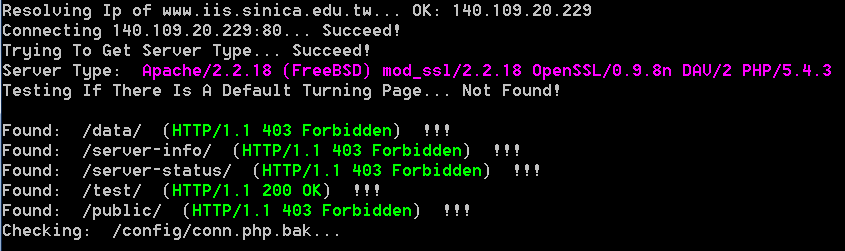

0x01 wwwscan 实际测试速度还可以,编码 [应该是cmd默认的编码问题gbk] 貌似还有些问题,另外,程序写的有些过于死板,异常处理不太到位,误报稍微有些严重:1

2

3

4

5-p 指定目标web端口,因为有些web服务并非工作在默认的80或者8080上,需要手工指定目标的web服务端口

-m 指定扫描使用的最大线程,不要太大,实际中15到20就差不多了

-t 指定请求的超时时间

--ssl 扫描https站点时记得加上此选项

-r 指定网站根目录,有些站点程序是放在web目录下的一个子目录中的,这时就需要你自己手工指定目标网站根目录

1 | # wwwscan.exe cems09.ce.ust.hk -m 10 -t 20 -p 80 扫iis |

1 | # wwwscan.exe www.rainbowsystem.com.hk -m 10 -t 20 -p 80 扫apache |

1 | # wwwscan.exe 203.72.29.166 -m 10 -t 20 -p 80 直接指定目标ip扫也是可以的 |

1 | # wwwscan.exe www.iis.sinica.edu.tw -m 20 -t 10 --ssl 扫描https |

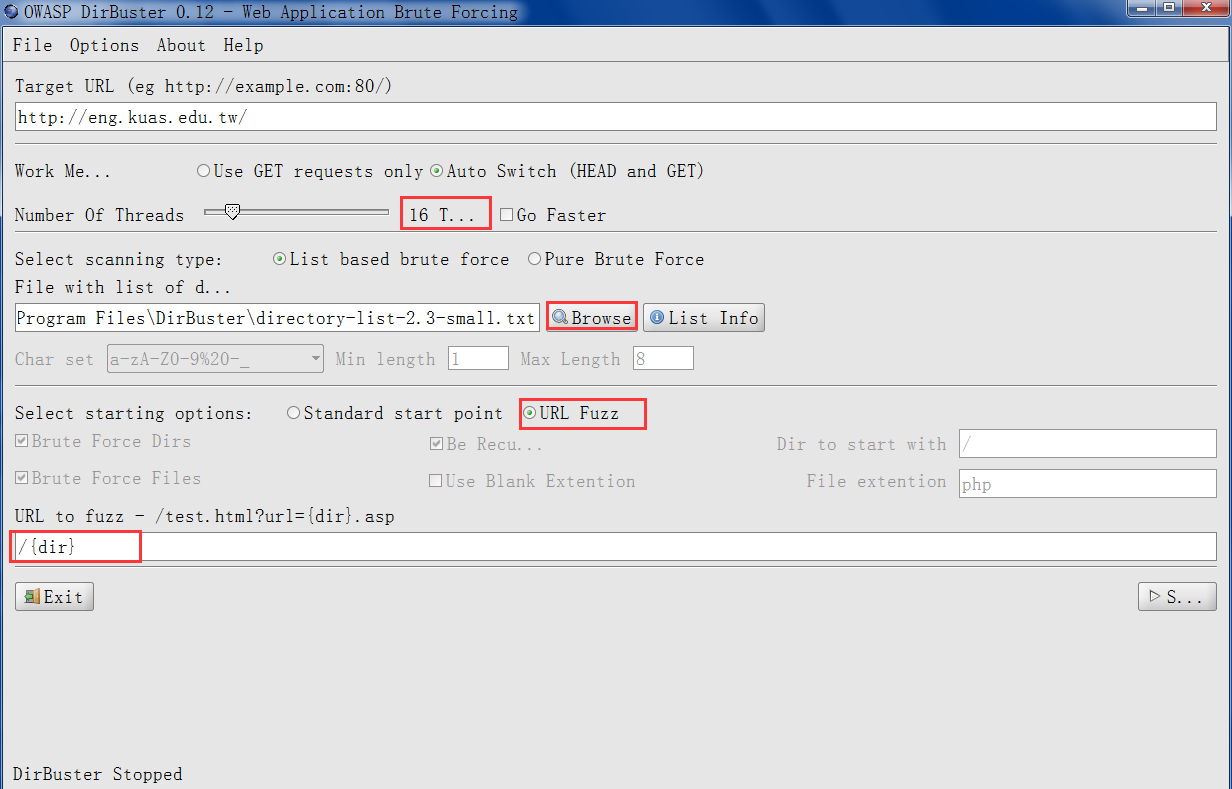

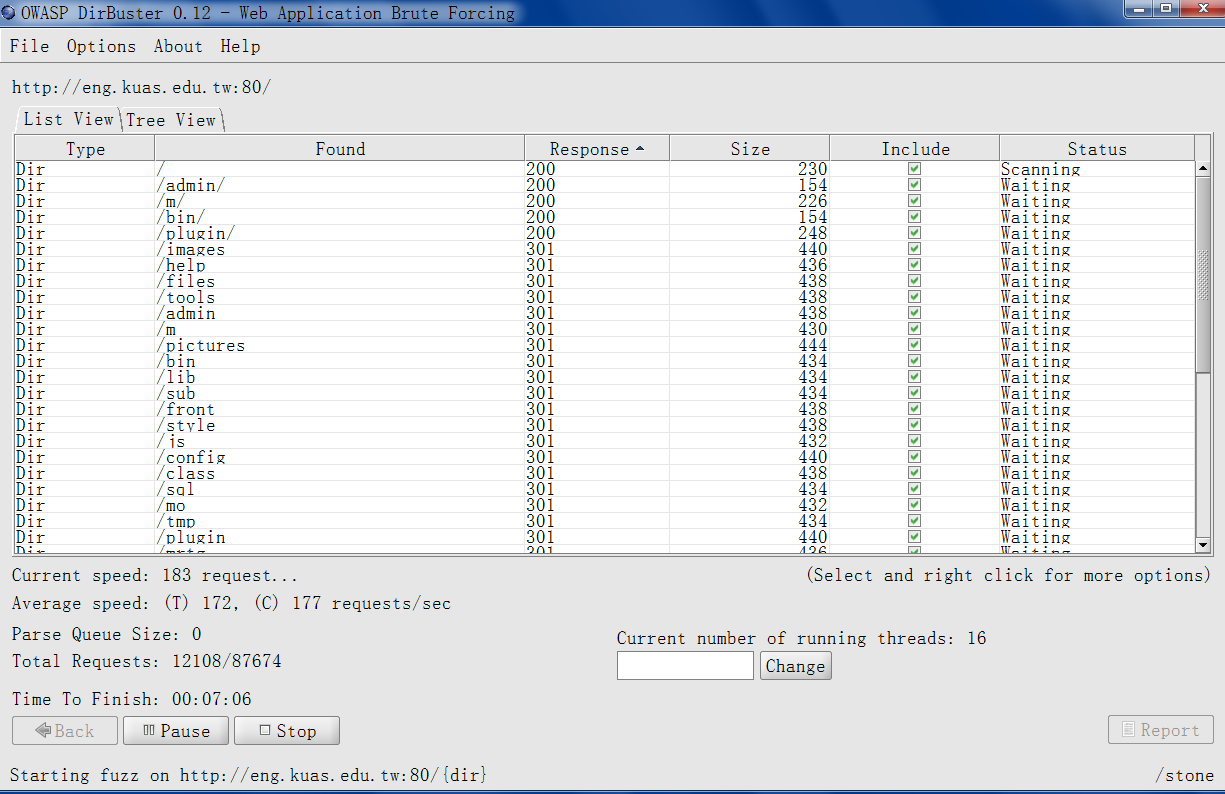

0x02 DirBuster 另一款基于java编写的爬行及目录扫描工具,既是java程序,jre是必须的,纯图形化界面,用法相对比较灵活,极易上手:1

2

3

4

5

6

7不过,在使用之前,我们还需要先稍微设置下,改下默认的user-agent和扫描请求的超时时间

把工具自身的自动更新也关掉,任何工具都是如此,把更新关掉,对你肯定是有好处的

打开程序主界面,贴上目标域名,扫描时的请求方法让它自动即可

设置好线程,推荐20-25之间,太大了容易把网站扫死,选好字典文件,使用url fuzzing方式进行扫描,进行fuzzing设置的时候,需要注意下

比如你扫的目标是 http://www.xxx.com/la/ 这种形式的, 那你在url to fuzz里面就要写成/la/{dir}

意思也就是说{dir}是一个变量,用它来替换字典中的每一行

在{dir}的前后可以随意拼接你想要的后缀或者目录,比如:/admin/{dir}.php就表示扫描admin目录下的所有php文件

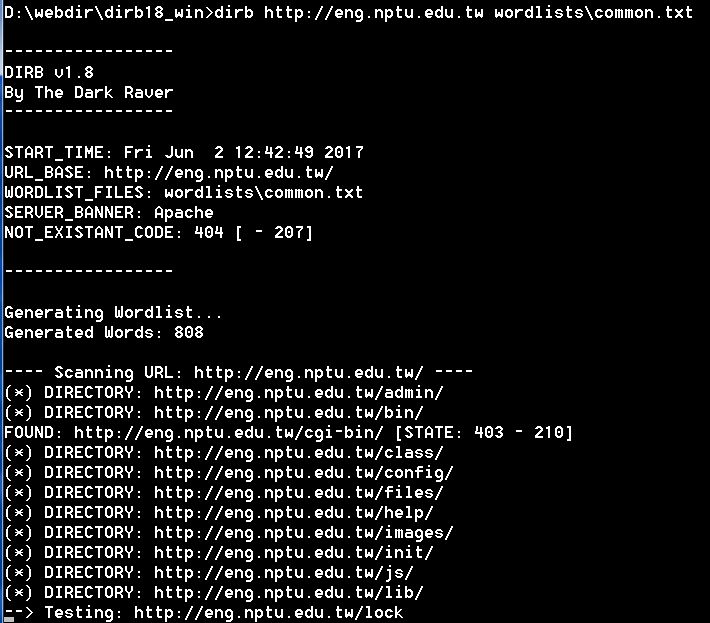

0x03 dirb 一款比较老旧的目录扫描工具,后面可以同时连续跟上多个目录字典,它会先扫目录,当所有目录都扫完以后,再自动挨个遍历已扫到目录下的文件和子目录,根据执行过程再看,很显然是一层层递归的,速度一般:1

# dirb http://eng.nptu.edu.tw wordlists\common.txt

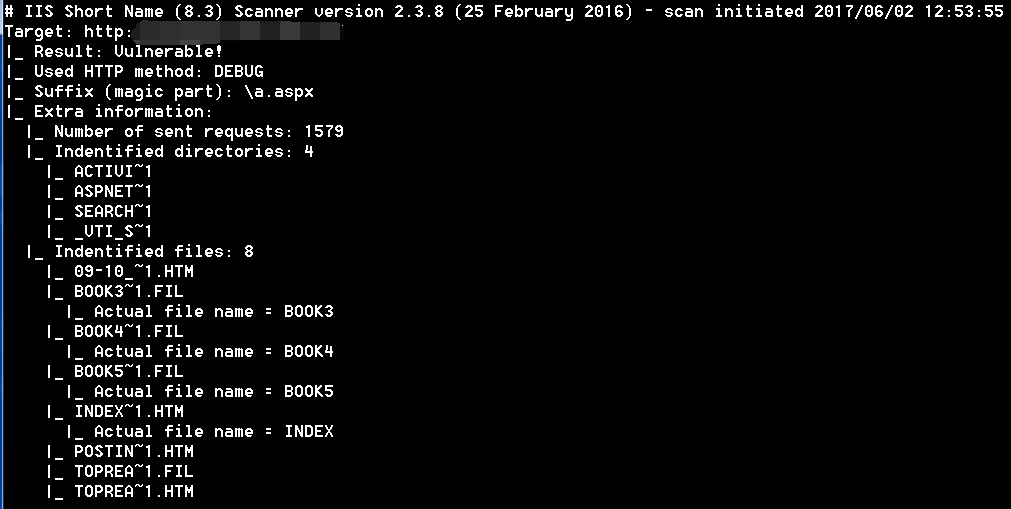

0x03 iis_shortname_scanner 基于java 1.7编译,最好也用jdk1.7版本来运行,短文件漏洞扫描,在漏洞存在的情况下,扫描速度还是非常快的,对于扫windows服务器目录推荐优先用它:1

# java -jar iis_shortname_scanner.jar 2 10 http://www.target.hk/ 前面的数字表示显示扫描过程中的信息的详细程度,后面的数字表示线程,还是那句话不宜太高

0x05 burpsuite 估计也是大家用的最多的渗透工具,就不多介绍了:1

2

3同是基于java的工具,用它跑目录其实也是可以的,只不过字典不能太大,实际测试中1w就非常吃力了

建议直接跑一些命中率比较高的精简目录,纯图形化工具,使用也比较简单就不多说了

关于此工具的更多用途,在之前已经详细说明过,这里就不再啰嗦了,把状态码和数据长度排序下就能看到扫描结果了

0x06 最后,就是其它各种py目录扫描小脚本,这里就不一一介绍了,github上这种东西多如牛毛,后期遇到好的,会再补充上来1

2cscan 谷歌小插件,误报非常高,但曾经确实就用它收获过,具体原理是啥,暂时还没搞清楚

各类py脚本,非常多,这里就不细说了

0x07 除此之外,还有非常多的一些在线工具站,不妨也可以用下,虽然不报太大希望,但惊喜往往出现在不经意间:1

2

3https://pentest-tools.com

https://hackertarget.com/

...

一点小结:

对于这类工具的具体实现基本都大同小异,无非就是在目标域名后面拼接字典中的路径,然后逐个请求(多线程),观察响应状态码和返回的数据长度变化,head方法因为不返回详细主体,响应速度会相对比较快,不过,对于head这种敏感方法,稍微有点儿经验的管理员在服务器端都会把它禁用掉,另外还需要注意的是,这样的扫描会在对方的web日志中留下大批量的请求记录,如果你的字典过大,可能会直接导致对方web日志文件大小短时间内剧增而触发报警……所以,适量即可,还有最重要的一点,网站目录字典一定要自己精心制作,搜集各种命中率相对比较高的敏感特征目录文件确实是个体力活,关于敏感文件有哪些,在前面的章节中已经详细汇总过,不清楚的地方请直接查看相关说明……,没啥技术含量,总之,非常期待能和大家一起交流学习进步…